# 数据分析

数据分析的价值主要在于熟悉了解整个数据集的基本情况包括每个文件里有哪些数据,具体的文件中的每个字段表示什么实际含义,以及数据集中特征之间的相关性,在推荐场景下主要就是分析用户本身的基本属性,文章基本属性,以及用户和文章交互的一些分布,这些都有利于后面的召回策略的选择,以及特征工程。

建议:当特征工程和模型调参已经很难继续上分了,可以回来在重新从新的角度去分析这些数据,或许可以找到上分的灵感

导包

1 | # 导入相关包 |

读取数据

1 | path = './data_raw/' |

数据预处理

计算用户点击rank和点击次数

1 | # 对每个用户的点击时间戳进行排序 |

1 | #计算用户点击文章的次数,并添加新的一列count |

数据浏览

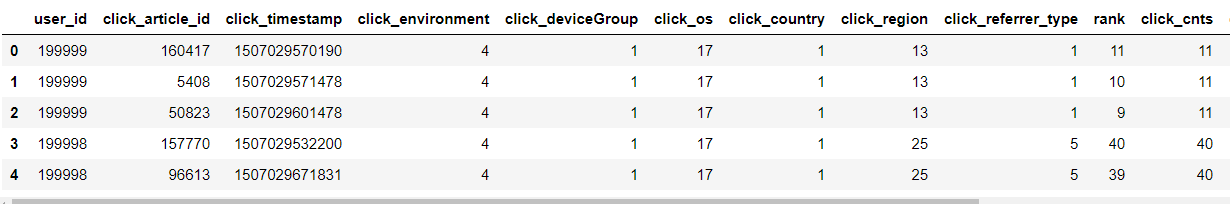

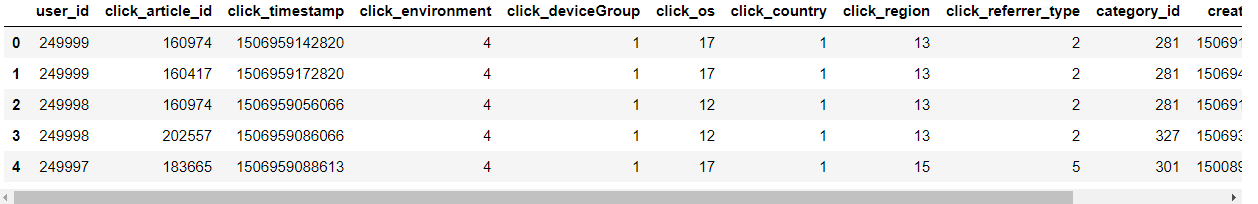

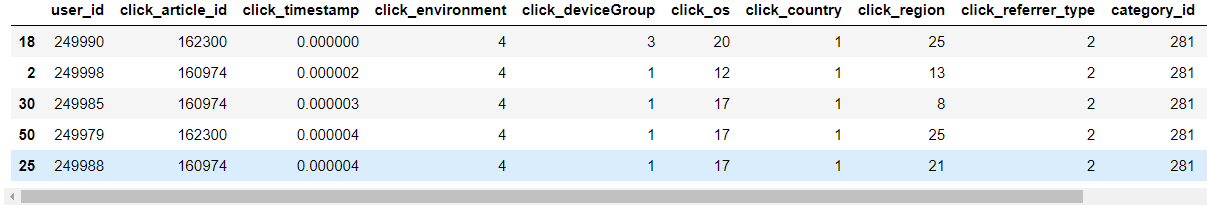

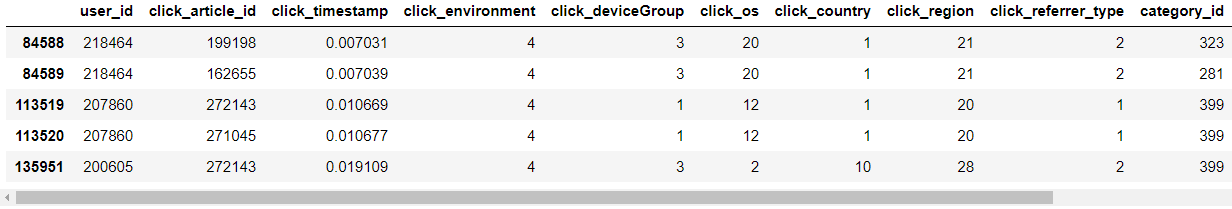

用户点击日志文件_训练集

1 | trn_click = trn_click.merge(item_df, how='left', on=['click_article_id']) |

train_click_log.csv文件数据中每个字段的含义

- user_id: 用户的唯一标识

- click_article_id: 用户点击的文章唯一标识

- click_timestamp: 用户点击文章时的时间戳

- click_environment: 用户点击文章的环境

- click_deviceGroup: 用户点击文章的设备组

- click_os: 用户点击文章时的操作系统

- click_country: 用户点击文章时的所在的国家

- click_region: 用户点击文章时所在的区域

- click_referrer_type: 用户点击文章时,文章的来源

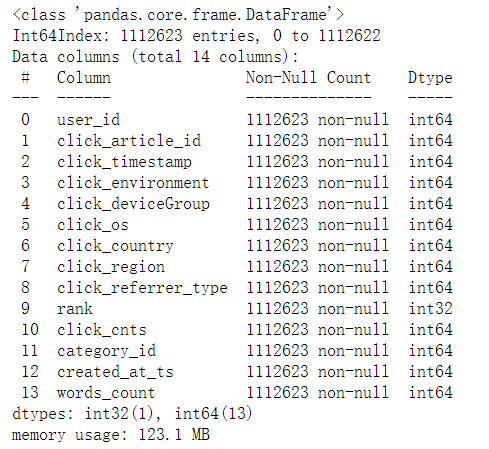

1 | #用户点击日志信息 |

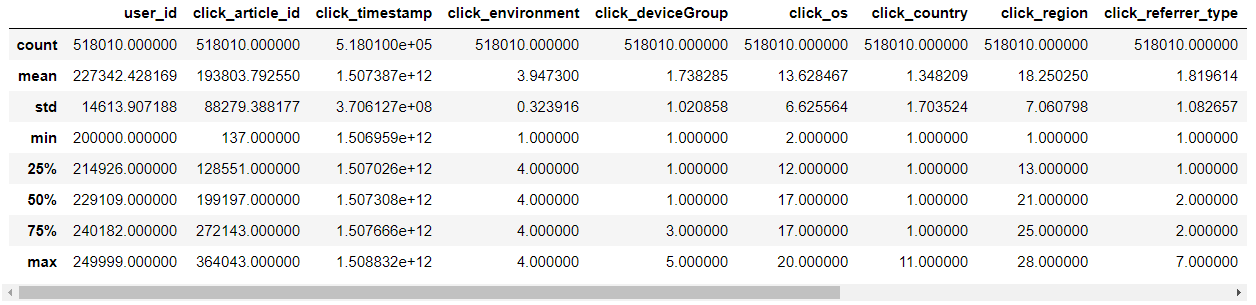

1 | trn_click.describe() |

1 | #训练集中的用户数量为20w |

2000001 | trn_click.groupby('user_id')['click_article_id'].count().min() # 训练集里面每个用户至少点击了两篇文章 |

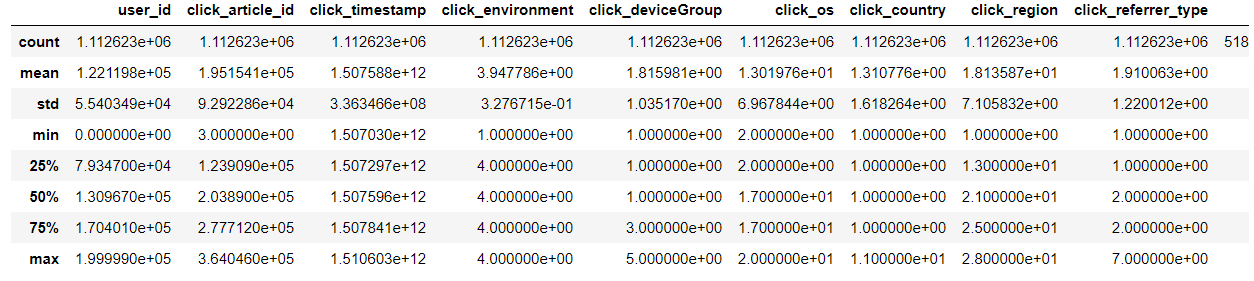

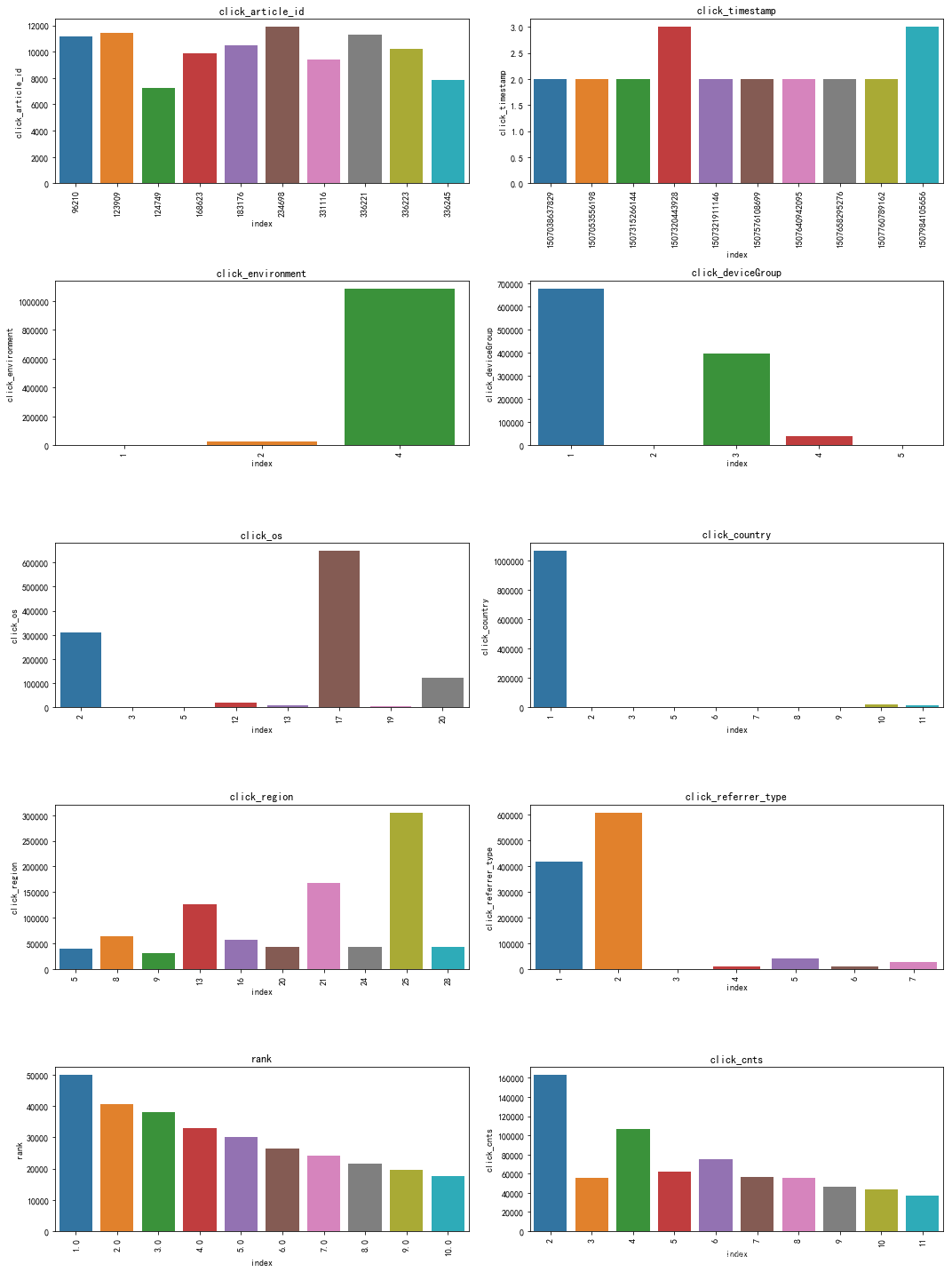

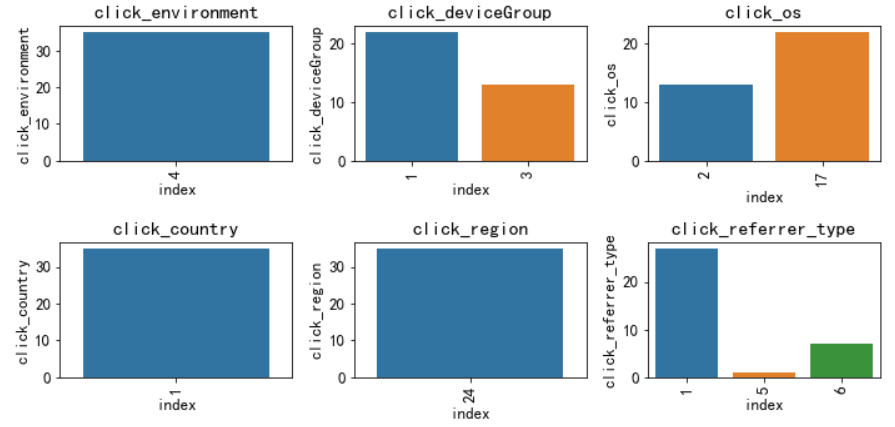

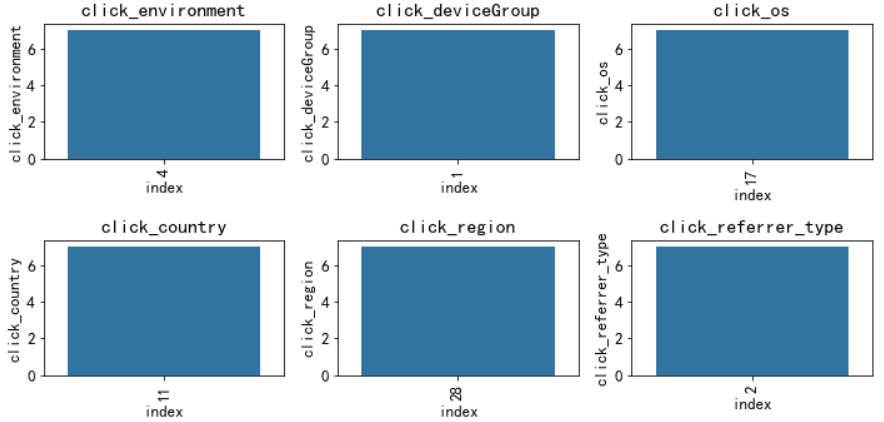

2画直方图大体看一下基本的属性分布

1 | plt.figure() |

从点击时间clik_timestamp来看,分布较为平均,可不做特殊处理。由于时间戳是13位的,后续将时间格式转换成10位方便计算。

从点击环境click_environment来看,仅有1922次(占0.1%)点击环境为1;仅有24617次(占2.3%)点击环境为2;剩余(占97.6%)点击环境为4。

从点击设备组click_deviceGroup来看,设备1占大部分(60.4%),设备3占36%。

测试集用户点击日志

1 | tst_click = tst_click.merge(item_df, how='left', on=['click_article_id']) |

1 | tst_click.describe() |

我们可以看出训练集和测试集的用户是完全不一样的

训练集的用户ID由0 ~ 199999,而测试集A的用户ID由200000 ~ 249999。

1 | #测试集中的用户数量为5w |

500001 | tst_click.groupby('user_id')['click_article_id'].count().min() # 注意测试集里面有只点击过一次文章的用户 |

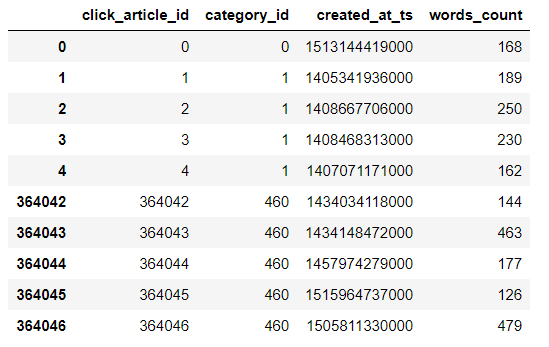

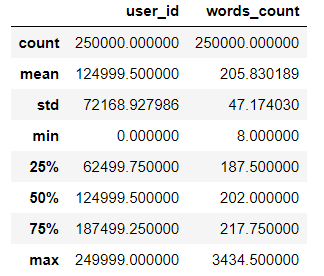

1新闻文章信息数据表

1 | #新闻文章数据集浏览 |

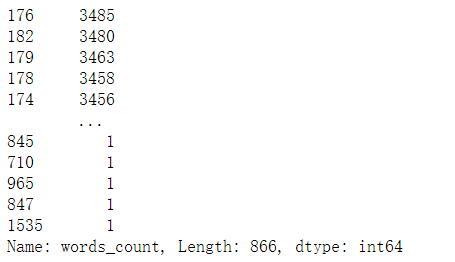

1 | item_df['words_count'].value_counts() |

1 | print(item_df['category_id'].nunique()) # 461个文章主题 |

1 | item_df.shape # 364047篇文章 |

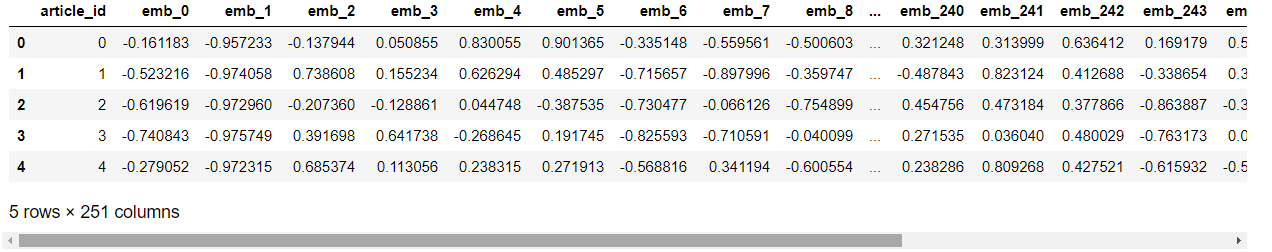

(364047, 4)新闻文章embedding向量表示

1 | item_emb_df.head() |

1 | item_emb_df.shape |

(364047, 251)数据分析

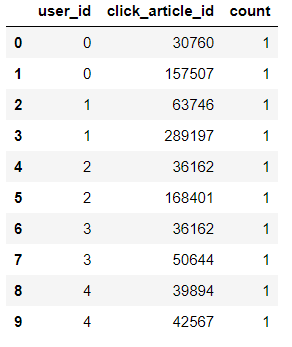

用户重复点击

1 | #####merge |

1 | #用户重复点击 |

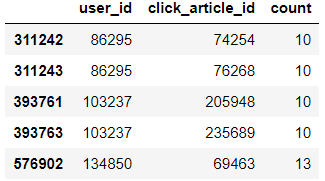

1 | user_click_count[user_click_count['count']>7] |

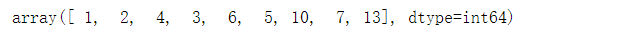

1 | user_click_count['count'].unique() |

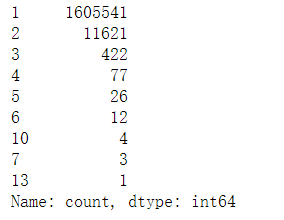

1 | #用户点击新闻次数 |

可以看出:有1605541(约占99.2%)的用户未重复阅读过文章,仅有极少数用户重复点击过某篇文章。 这个也可以单独制作成特征

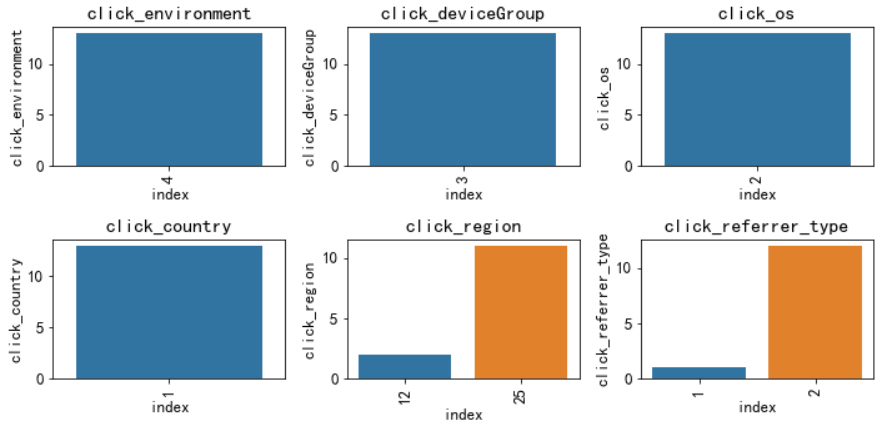

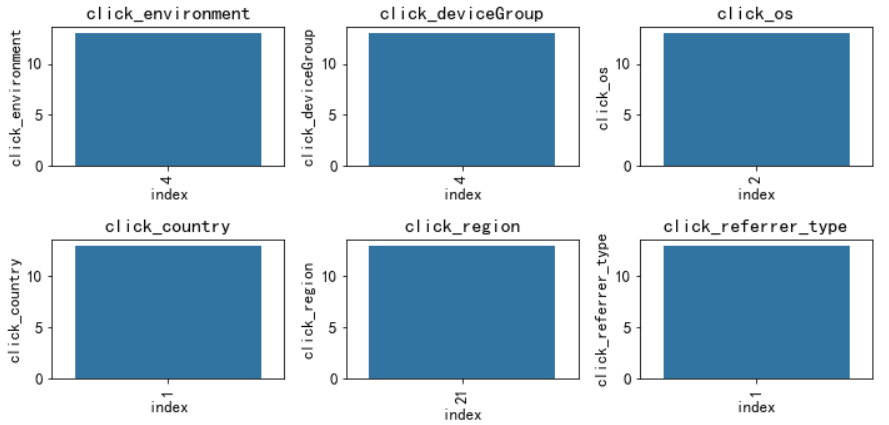

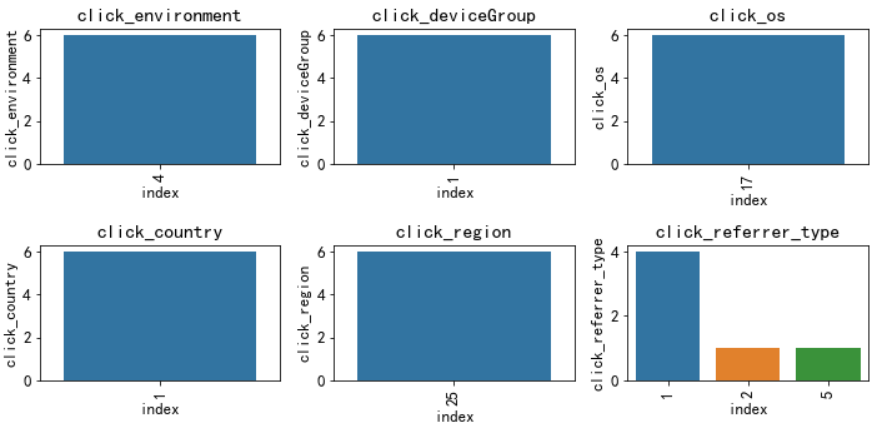

用户点击环境变化分析

1 | def plot_envs(df, cols, r, c): |

1 | # 分析用户点击环境变化是否明显,这里随机采样10个用户分析这些用户的点击环境分布 |

可以看出绝大多数数的用户的点击环境是比较固定的。思路:可以基于这些环境的统计特征来代表该用户本身的属性

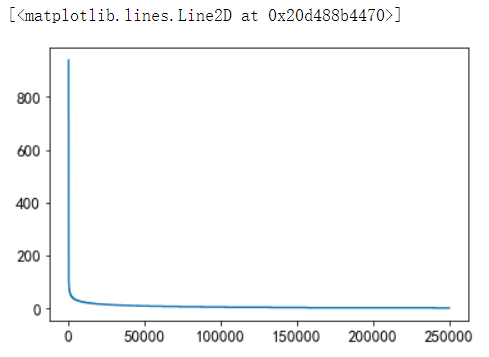

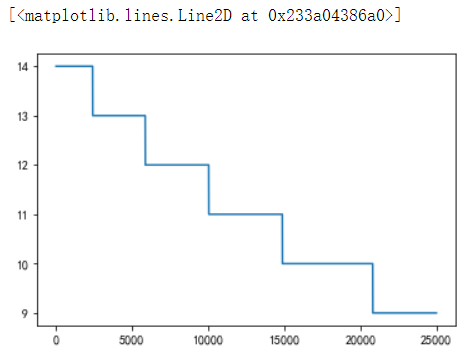

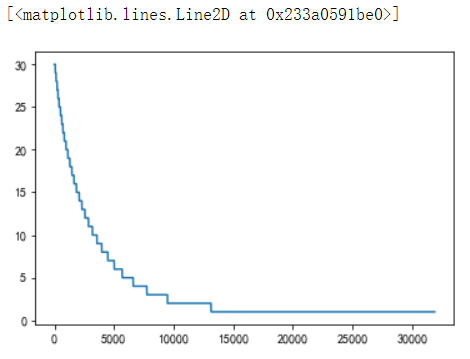

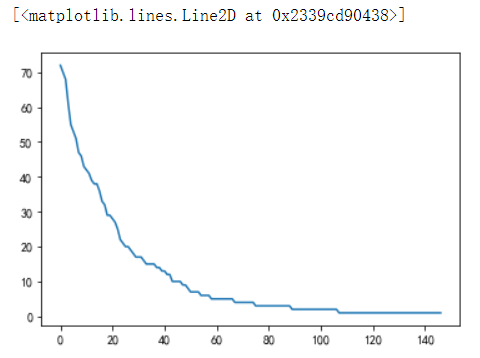

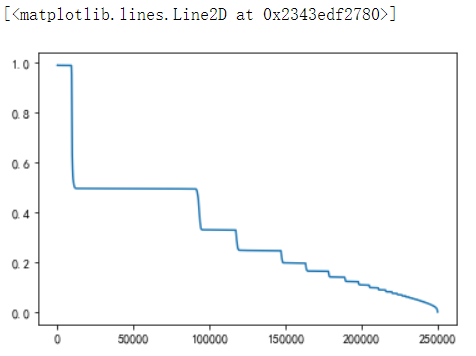

用户点击新闻数量的分布

1 | user_click_item_count = sorted(user_click_merge.groupby('user_id')['click_article_id'].count(), reverse=True) |

可以根据用户的点击文章次数看出用户的活跃度

1 | #点击次数在前50的用户 |

点击次数排前50的用户的点击次数都在100次以上。思路:我们可以定义点击次数大于等于100次的用户为活跃用户,这是一种简单的处理思路, 判断用户活跃度,更加全面的是再结合上点击时间,后面我们会基于点击次数和点击时间两个方面来判断用户活跃度。

1 | #点击次数排名在[25000:50000]之间 |

可以看出点击次数小于等于两次的用户非常的多,这些用户可以认为是非活跃用户

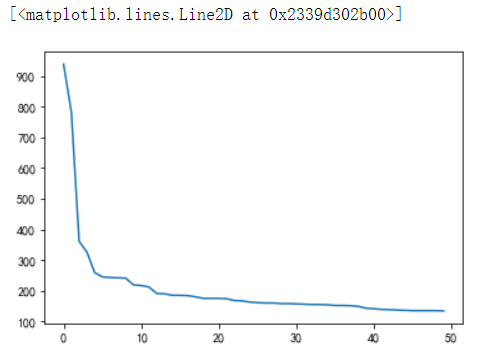

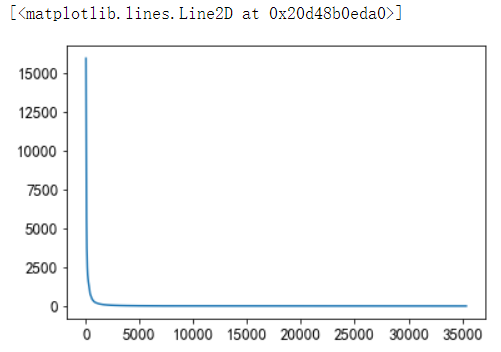

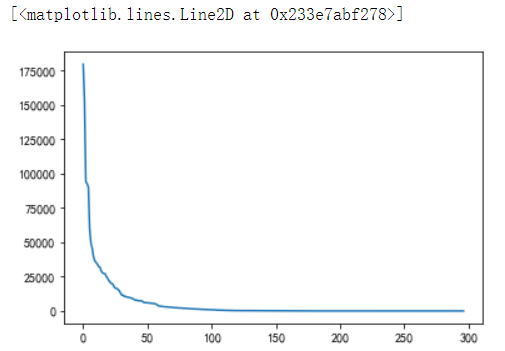

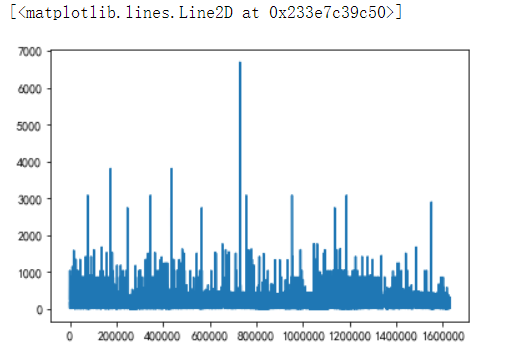

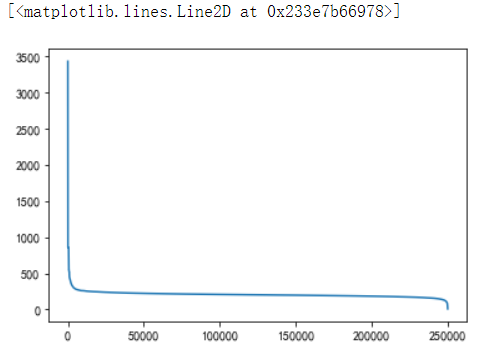

新闻点击次数分析

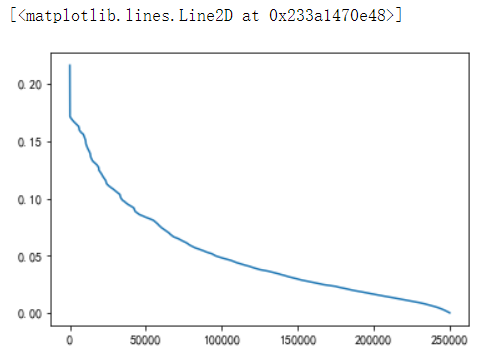

1 | item_click_count = sorted(user_click_merge.groupby('click_article_id')['user_id'].count(), reverse=True) |

1 | plt.plot(item_click_count) |

1 | plt.plot(item_click_count[:100]) |

可以看出点击次数最多的前100篇新闻,点击次数大于1000次

1 | plt.plot(item_click_count[:20]) |

点击次数最多的前20篇新闻,点击次数大于2500。思路:可以定义这些新闻为热门新闻, 这个也是简单的处理方式,后面我们也是根据点击次数和时间进行文章热度的一个划分。

1 | plt.plot(item_click_count[3500:]) |

可以发现很多新闻只被点击过一两次。思路:可以定义这些新闻是冷门新闻。

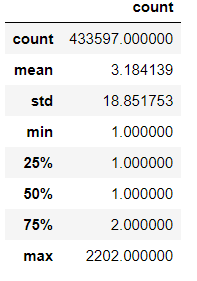

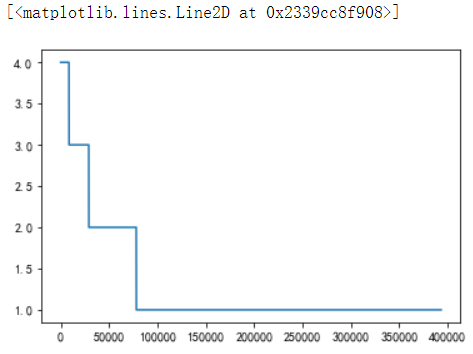

新闻共现频次:两篇新闻连续出现的次数

1 | tmp = user_click_merge.sort_values('click_timestamp') |

由统计数据可以看出,平均共现次数2.88,最高为1687。

说明用户看的新闻,相关性是比较强的。

1 | #画个图直观地看一看 |

1 | plt.plot(union_item['count'].values[40000:]) |

大概有70000个pair至少共现一次。

新闻文章信息

1 | #不同类型的新闻出现的次数 |

1 | #出现次数比较少的新闻类型, 有些新闻类型,基本上就出现过几次 |

1 | #新闻字数的描述性统计 |

1 | plt.plot(user_click_merge['words_count'].values) |

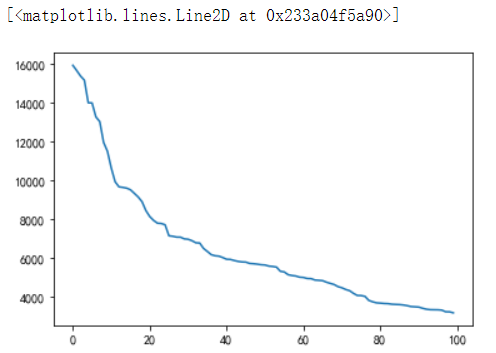

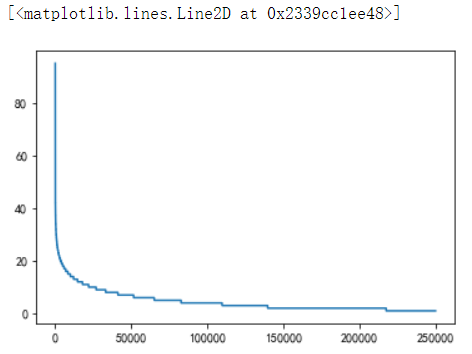

用户点击的新闻类型的偏好

此特征可以用于度量用户的兴趣是否广泛。

1 | plt.plot(sorted(user_click_merge.groupby('user_id')['category_id'].nunique(), reverse=True)) |

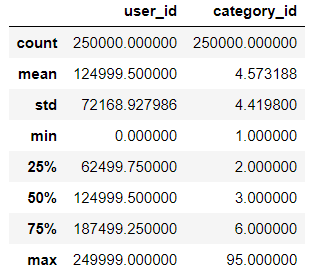

从上图中可以看出有一小部分用户阅读类型是极其广泛的,大部分人都处在20个新闻类型以下。

1 | user_click_merge.groupby('user_id')['category_id'].nunique().reset_index().describe() |

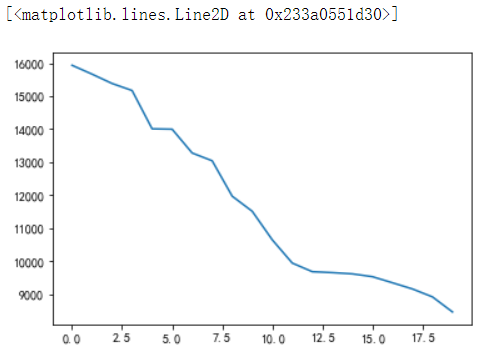

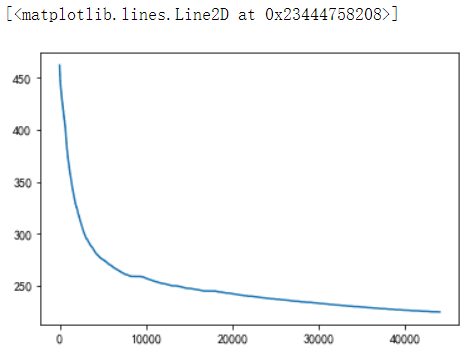

用户查看文章的长度的分布

通过统计不同用户点击新闻的平均字数,这个可以反映用户是对长文更感兴趣还是对短文更感兴趣。

1 | plt.plot(sorted(user_click_merge.groupby('user_id')['words_count'].mean(), reverse=True)) |

从上图中可以发现有一小部分人看的文章平均词数非常高,也有一小部分人看的平均文章次数非常低。

大多数人偏好于阅读字数在200-400字之间的新闻。

1 | #挑出大多数人的区间仔细看看 |

可以发现大多数人都是看250字以下的文章

1 | #更加详细的参数 |

用户点击新闻的时间分析

1 | #为了更好的可视化,这里把时间进行归一化操作 |

1 | user_click_merge.head() |

1 | def mean_diff_time_func(df, col): |

1 | # 点击时间差的平均值 |

1 | plt.plot(sorted(mean_diff_click_time.values, reverse=True)) |

从上图可以发现不同用户点击文章的时间差是有差异的。

1 | # 前后点击文章的创建时间差的平均值 |

1 | plt.plot(sorted(mean_diff_created_time.values, reverse=True)) |

从图中可以发现用户先后点击文章,文章的创建时间也是有差异的

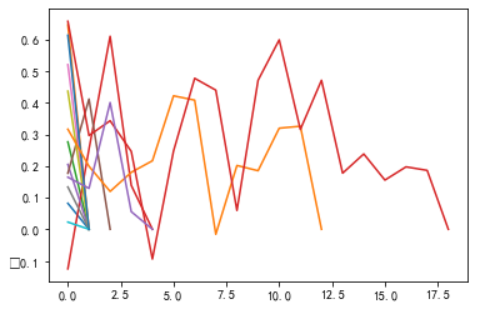

1 | # 用户前后点击文章的相似性分布 |

1 | del item_emb_df['article_id'] |

1 | item_emb_np = np.ascontiguousarray(item_emb_df.values, dtype=np.float32) |

1 | # 随机选择5个用户,查看这些用户前后查看文章的相似性 |

1 | def get_item_sim_list(df): |

1 | for _, user_df in sub_user_info.groupby('user_id'): |

从图中可以看出有些用户前后看的商品的相似度波动比较大,有些波动比较小,也是有一定的区分度的。

总结

通过数据分析的过程, 我们目前可以得到以下几点重要的信息, 这个对于我们进行后面的特征制作和分析非常有帮助:

- 训练集和测试集的用户id没有重复,也就是测试集里面的用户没有模型是没有见过的

- 训练集中用户最少的点击文章数是2, 而测试集里面用户最少的点击文章数是1

- 用户对于文章存在重复点击的情况, 但这个都存在于训练集里面

- 同一用户的点击环境存在不唯一的情况,后面做这部分特征的时候可以采用统计特征

- 用户点击文章的次数有很大的区分度,后面可以根据这个制作衡量用户活跃度的特征

- 文章被用户点击的次数也有很大的区分度,后面可以根据这个制作衡量文章热度的特征

- 用户看的新闻,相关性是比较强的,所以往往我们判断用户是否对某篇文章感兴趣的时候, 在很大程度上会和他历史点击过的文章有关

- 用户点击的文章字数有比较大的区别, 这个可以反映用户对于文章字数的区别

- 用户点击过的文章主题也有很大的区别, 这个可以反映用户的主题偏好

10.不同用户点击文章的时间差也会有所区别, 这个可以反映用户对于文章时效性的偏好

所以根据上面的一些分析,可以更好的帮助我们后面做好特征工程, 充分挖掘数据的隐含信息。